AI-historia – artificiell intelligens då och nu

Människan har under hela sin historia fascinerats av intelligens som är konstgjord. Från mytologiska sagoväsen ristade på stentavlor till dagens avancerade AI-teknik som kan hjälpa oss med allt från programmering till recept på pannkakor.

AI är en förkortning för artificiell intelligens. Det är ett samlingsnamn för en rad olika teknologier som försöker få maskiner och datorprogram att fungera mer likt en människa. Det handlar till exempel om att kunna resonera och planera, förstå vanligt språk, kunna lära sig av data, känna igen mönster och lägga ihop flera olika intryck för att komma fram till en slutsats.

I utställningen AI-historia gör vi nedslag i hur människor tänkt om konstgjort intelligent liv innan datorer fanns och i den artificiella intelligensens utveckling. Från forntida berättelser till schackspelande datorer, mer eller mindre lyckade chattbotar och världens första AI-lagstiftning.

"AI" innan datorn

Artificiell intelligens är starkt förknippat med datorer och datavetenskap, men människor har tänkt kring konstgjort intelligent liv och robotar långt innan de första datorerna byggdes på 1940-talet. Dessa tankar har framför allt synts i olika civilisationers mytologier, i litteratur och på film.

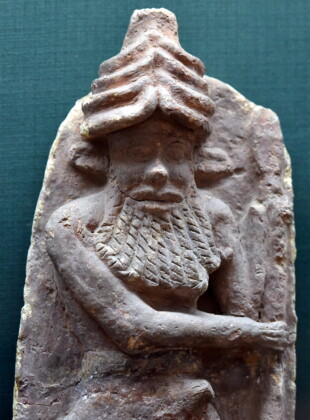

Gudinnan Aruru formar intelligent liv av lite lera

Ett av de tidigaste kända exemplen på tanken om konstgjort intelligent liv kommer från den sumeriska civilisationen i Mesopotamien.

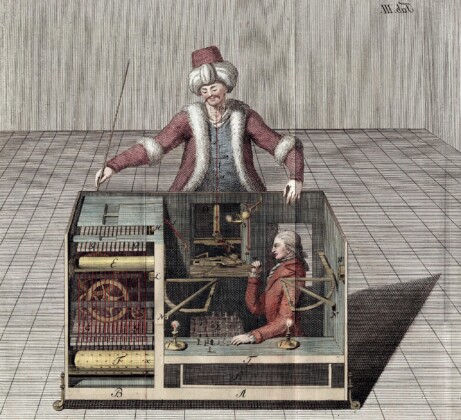

Den mekaniska turken vinner mot alla i schack

På 1700-talet blev det populärt bland rika aristokrater att visa upp "automata". En slags tidiga mekaniska robotar och apparater som rörde sig som verkliga djur eller människor, men egentligen drevs av uppdragbara fjädrar eller ånga.

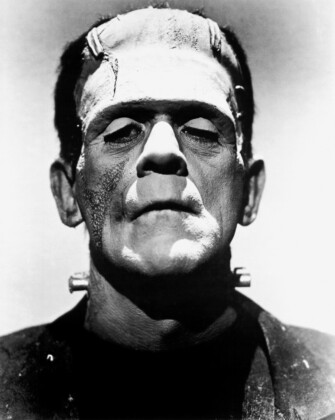

Frankenstein blir den första "AI‑romanen"

Konstgjort liv har funnits länge som tema i litteraturen. År 1818 gav författaren Mary Shelley ut den banbrytande romanen Frankenstein.

Matematikgeniet Ada Lovelace skapar den första datoralgoritmen

Ada Lovelace föddes in i den engelska societeten och var knappast förutbestämd att bli matematiker. Men det blev hon – och mer därtill.

Filmhistoriens första AI - maskinmänniskan "Maria" i Metropolis

Under 1900-talet blev både robotar och AI populära inslag att visa på film, med både goda och onda exempel.

Isaac Asimov berättar om tänkande robotar och deras lagar

En av de största science fiction-författarna är Isaac Asimov som i sina romaner beskriver robotar bundna av lagar för att skydda människorna.

AI under dataåldern

Datorer har varit avgörande för utvecklingen av artificiell intelligens. Med deras förmåga att snabbt bearbeta stora mängder data och utföra komplexa beräkningar, har datorer gjort det möjligt att skapa och träna AI-system.

Dessa system kan utföra uppgifter som tidigare bara människor kunde göra, som att känna igen tal och bilder, spela schack och köra bilar. Ibland till och med bättre än människor. Utan datorer skulle framstegen inom AI inte vara möjliga.

Alan Turings test avgör om en dator verkligen är "intelligent"

Alan Turing, brittisk matematiker och kryptoanalytiker, anses vara en av de viktigaste personerna bakom datorernas utveckling på 1900-talet.

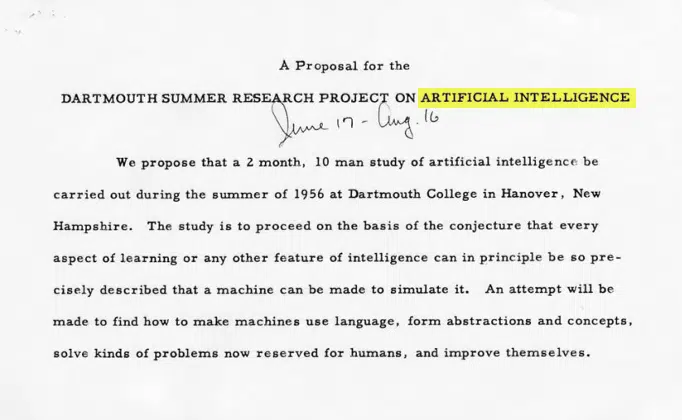

Begreppet "artificiell intelligens" myntas

Under början av 1950-talet fanns det många olika områden för forskning om "tänkande maskiner".

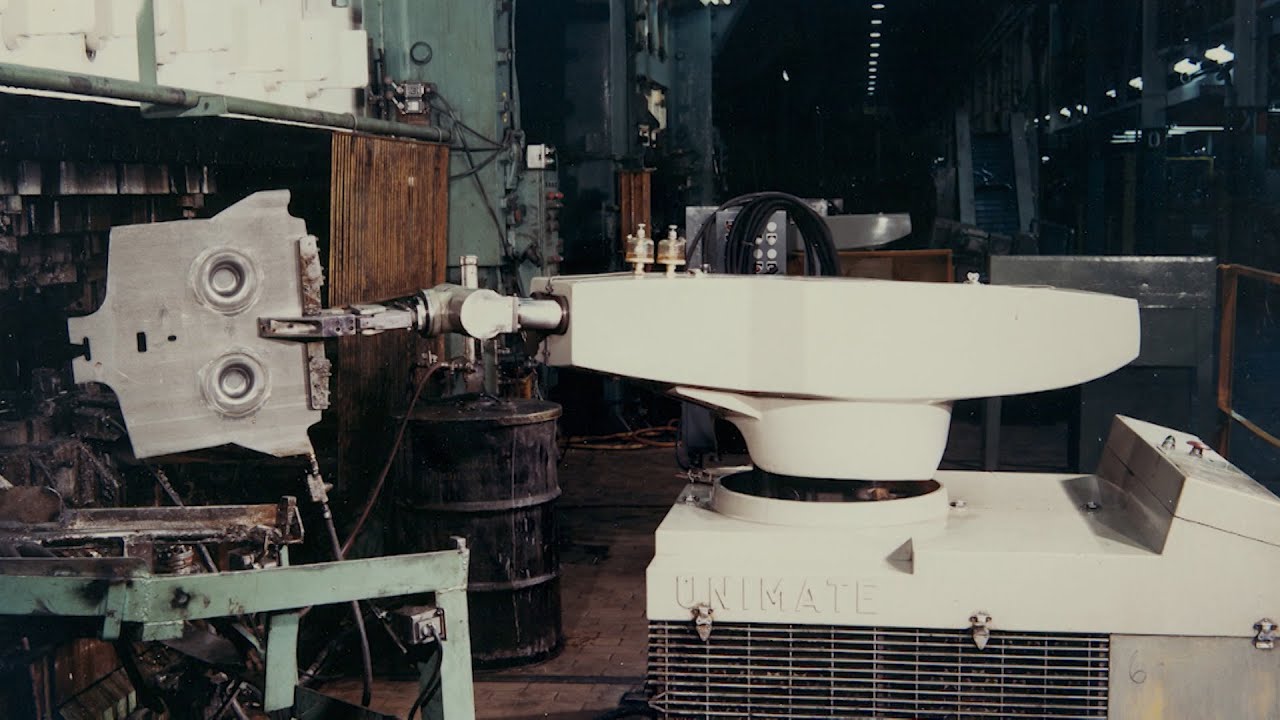

Den första fungerande roboten var en arm

Idén om att artificiella varelser skulle kunna tänka själva slog rot hos många under 1900-talet. Uppfinnare tävlade om att bygga den första riktiga roboten.

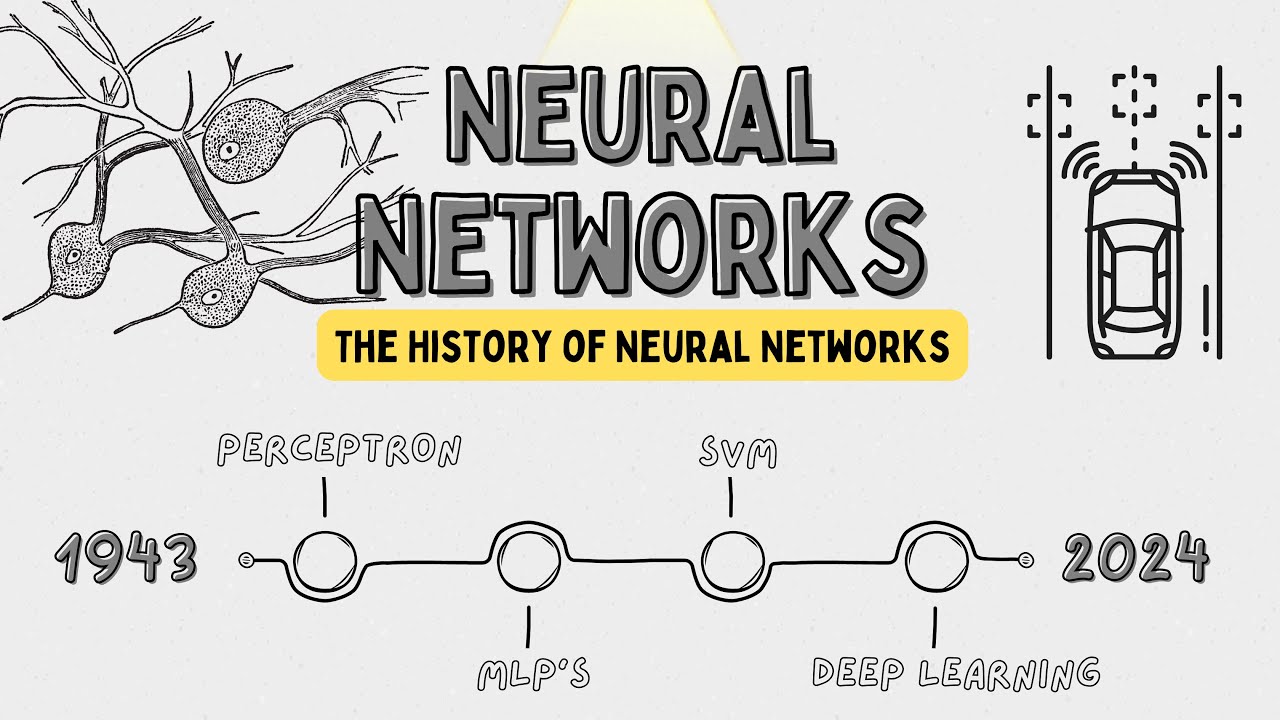

AI börjar efterlikna den mänskliga hjärnan

Neurala nätverk är datorsystem som genom självlärande algoritmer försöker efterlikna den mänskliga hjärnans nätverk av nervceller (neuroner).

Gordon Moore formulerar "Moores lag"

Datorerna under 1940- och 50-talet var väldigt långsamma, men utvecklingen gjorde att de ständigt blev allt snabbare. För att mäta detta används "Moores lag".

Eliza – den första chattbotten

ELIZA var en av de första chattbottarna och utvecklades av Joseph Weizenbaum mellan 1964 och 1967. Programmet skapades för att utforska kommunikation mellan människor och maskiner.

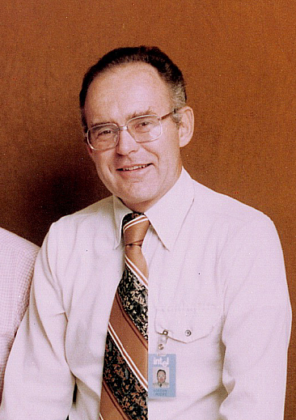

Erik Sandewall blir Sveriges första AI-professor

Erik Sandewall är en av de mest framstående pionjärerna inom AI-forskning i Sverige. Han spelade en avgörande roll i att introducera och etablera artificiell intelligens som ett akademiskt forskningsområde i landet.

Commodore 64 börjar säljas och barn kan nu spela mot "AI-motståndare"

Under 1980-talet började datorn ta plats i svenska hem på allvar. En av de mest populära var hemdatorn Commodore 64 med sina många spel.

Androider charmar och skrämmer i tv‑rutan

Det är inte bara på böcker och film som artificiell intelligens kittlat vår fantasi. Några av kulturens mest kända robotar kommer från tv-serier och Sverige står för en av succéerna.

Datorn Deep Blue besegrar världsmästaren i schack

Ända sedan den mekaniska turken på 1700-talet hade idén funnits kvar om att datorer en dag skulle kunna slå oss i schack. Och år 1996 blev det verklighet.

Darpa Grand Challenge – tävling med självkörande bilar

Självkörande bilar har länge varit en självklar del av framtidsskildringar på film, men kommer det någonsin att bli verklighet? Tävlingen DARPA Grand Challenge satsar på det!

Karen Spärck Jones: "Datavetenskap är för viktigt för att lämnas till männen"

AI-forskningen har länge varit kraftigt mansdominerad, precis som många andra områden inom teknik. Men självklart har det funnits – och finns – många kvinnor som gjort banbrytande och viktiga bidrag till forskningen om AI.

Fei-Fei Li gör datorseende mer klarsynt med ImageNet

Fei-Fei Li är en ledande forskare inom datorseende, en gren av AI som fokuserar på hur datorer kan tolka och förstå bilder och video. Hon grundade ImageNet, en databas av bilder som revolutionerade utvecklingen av AI-system och djupinlärning.

Datorn Watson vinner frågesporten Jeopardy

På 90-talet bevisade datorn Deep Blue att den kunde besegra människan i schack. Men först 2011 började den artificiella intelligensen bemästra frågesportens värld.

ChatGPT – den magiska känslan av att datorn förstår oss

Den 30 november 2022 släpptes programmet ChatGPT till allmänheten. Det blev en chockvåg över internet när många för första gången kunde testa att chatta med en modern version av AI.

Nu är AI vardag, men imorgon?

Artificiell intelligens har idag letat sig in nästan överallt i våra datorer och mobiler. AI-utvecklingen går rasande fort och många företag experimenterar med halvfärdiga tjänster för att vara först ute.

En del forskare menar att den snabba utvecklingen av AI är farlig och borde begränsas. De är oroliga för att människan ska överlåta allt fler viktiga beslut till automatiska datorsystem.

Vissa varnar även för risken att en superintelligent AI, som är mycket smartare än människan, skulle kunna utplåna hela mänskligheten. De flesta experter anser dock att denna domedagsoro är överdriven och att det finns mer närliggande utmaningar att fokusera på.

När Internetstiftelsen började mäta svenskarnas AI-användning år 2023 svarade 3 av 10 svenskar att AI kommer att ha en övervägande negativ påverkan på samhället. Knappt 2 av 10 trodde att AI kommer att ha en övervägande positiv påverkan.

Internetstiftelsen börjar mäta svenskarnas AI-användning

Efter att ChatGPT släpptes den 30 november 2022 började intresset för AI växa på allvar. Flertalet kraftfulla AI-verktyg blev tillgängliga att använda gratis för vem som helst. Därför började Internetstiftelsen undersöka hur AI-användandet ser ut bland svenska internetanvändare.

Sverige får en egen språkmodell – GPT-3SWE

Den första stora generativa språkmodellen för svenska språket lanseras med en öppen licens. Svenska organisationer och företag kan nu använda modellen i sina egna tjänster och verktyg.

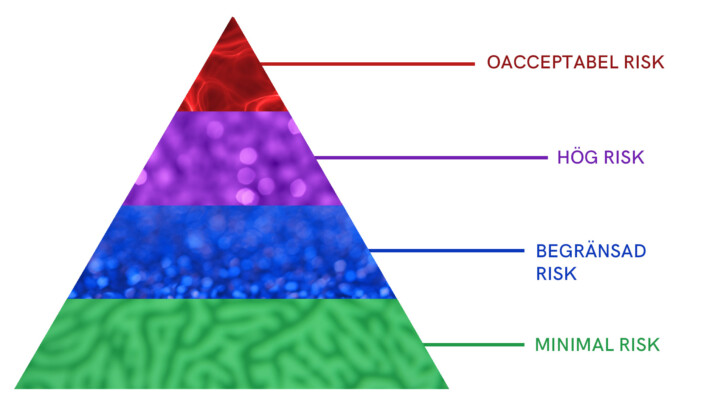

EU antar världens första AI-lagstiftning

För att hantera de många utmaningar och möjligheter som följer med den snabba utvecklingen av AI antog EU världens första AI-lagstiftning den 21 maj 2024.

AI ligger bakom två tunga nobelpris

Amerikanen John Hopfield och britten Geoffrey Hinton får 2024 år Nobelpris i fysik för upptäckter inom artificiella neuronnätverk och maskininlärning. AI ligger också bakom nobelpriset i kemi.

Historien om AI

Följande text är från Kungl. Vetenskapsakademiens skrift Vetenskapen säger – om AI. Den sammanfattar hur AI-utvecklingen har sett ut under olika årtionden, från 1940-talet till 2020-talet.

AI-utvecklingen har inte alltid gått spikrakt. Flera gånger har fältet bromsat in, för att sedan bli populärt igen, och så tappa fart än en gång. Ibland talar man om AI-utvecklingens årstider: somrar med snabba framsteg och blomstrande teknik, följt av vintrar med begränsningar, etiska utmaningar och pessimism.

1940-talet

AI-utvecklingen var ny, mer teoretisk än praktisk. Grunden för datavetenskap och maskinintelligens lades av bland andra matematikerna Alan Turing och John von Neumann. Redan 1936 presenterade Turing idén om en universell maskin som kunde räkna som en människa. Under andra världskriget arbetade han med kodknäckningsmaskiner som hade inslag av tidig AI.

1950- och 1960-talet

AI blev ett eget forskningsområde. Vid en konferens i Dartmouth 1956, organiserad av matematikern och datavetaren John McCarthy, myntades termen artificiell intelligens. Snart kom de första AI-drivna spelen. Datavetaren och psykologen Allen Newell och samhällsvetaren Herbert Simon utvecklade det första AI-programmet, Logic Theorist, som bevisade matematiska satser. Optimismen var stor men de praktiska framstegen små, eftersom datorernas kraft var så begränsad.

1970-talet

Erik Sandewall, professor i datalogi, tog AI-forskningen till Sverige och blev med tiden den första svenska AI-professorn. Forskningen vid den här tiden var riktad mot så kallade expertsystem som härmade mänsklig expertis inom specifika områden, som programmet MYCIN som skulle hjälpa läkare att diagnostisera och behandla svåra bakterieinfektioner (det testades, men infördes aldrig).

Men i mitten av decenniet fick det globala AI-fältet problem. Förväntningarna var för stora och många projekt gav inte de utlovade resultaten. Den senare hälften av 1970-talet brukar kallas för den första AI-vintern. Finansieringen och det allmänna intresset minskade.

1980-talet

Nu kom återhämtningen från förra decenniets "vinter". Forskarna hade tvingats omvärdera sina metoder, hårdvaran och algoritmerna blev bättre och förväntningarna mer realistiska. Maskininlärning och neurala nätverk fick fotfäste, och företag investerade stort i expertsystem inom bland annat medicin och på finansmarknaden.

Men tekniska utmaningar och hård konkurrens sänkte marknaden, och under den senare delen av decenniet gick många AI-bolag i konkurs. Systemen visade sig dyra att underhålla och uppdatera. Åren runt skiftet mellan 1980- och 90-talet räknas som den andra AI-vintern.

1990- och 2000-talet

På 1990-talet började maskininlärningsrevolutionen. Det skapades allt fler datadrivna och statistiska metoder och de nya teknikerna började användas inom språkbehandling, dator- seende och robotik. Forskare skapade fristående program som kunde interagera med varandra och med människor.

Detta lade grunden för modernare AI-system. Till exempel fick vi virtuella assistenter som klarade av att svara på frågor eller boka biljetter, och rekommendationsalgoritmer som används i sökmotorer och strömmande tjänster för musik och film.

2010-talet

Djupinlärning, en typ av maskininlärning, slog igenom och så kallade djupa neurala nätverk förbättrade AI:s kapacitet betydligt. När stora teknikföretag satsade kraftigt på AI-forskning ökade tempot ytterligare. Ny hårdvara som grafikprocessorer (GPU:er) spelade en avgörande roll för att träna djupinlärningsmodellerna.

Dessutom fanns nu stora mängder digitala data för systemen att träna på. AI började användas i självkörande fordon, inom vården och i digitala assistenter som Siri och Alexa. Arbetssättet i hela industrier började påverkas och AI blev en del av allt fler människors vardagsliv.

2020-talet

Djupinlärning har i dag en central plats i de flesta AI-tillämpningar och systemen kan hantera alltmer komplexa uppgifter. GPT visar vilken kapacitet djupinlärning har för naturlig språkförståelse och med hjälp av generativ AI skapas text, bilder och musik.

Under covid-19-pandemin bidrog AI både till att nya vaccin kunde designas så snabbt, och till att tillverkningen kunde skalas upp på ett effektivt sätt. Samtidigt har etiska frågor och behovet av AI-reglering börjat diskuteras på bred front.

Lär dig mer om AI

- Läs artikeln "Vad är AI för något" på sajten Internetkunskap

- Läs artikeln "Vilka risker finns det med AI" på sajten Internetkunskap

- Läs artikeln "AI är redan vardag" på sajten Internetkunskap

- Läs texten "Vetenskapen säger – om AI" på Kungl. Vetenskapsakademiens webbplats

- Se klippet "Computer History Museum – Artificial Intelligence" på Youtube