AI börjar efterlikna den mänskliga hjärnan

Neurala nätverk är datorsystem som genom självlärande algoritmer försöker efterlikna den mänskliga hjärnans nätverk av nervceller (neuroner).

Neurala nätverk kan med hjälp av data lära sig att känna igen mönster, bearbeta information, lösa problem och fatta beslut.

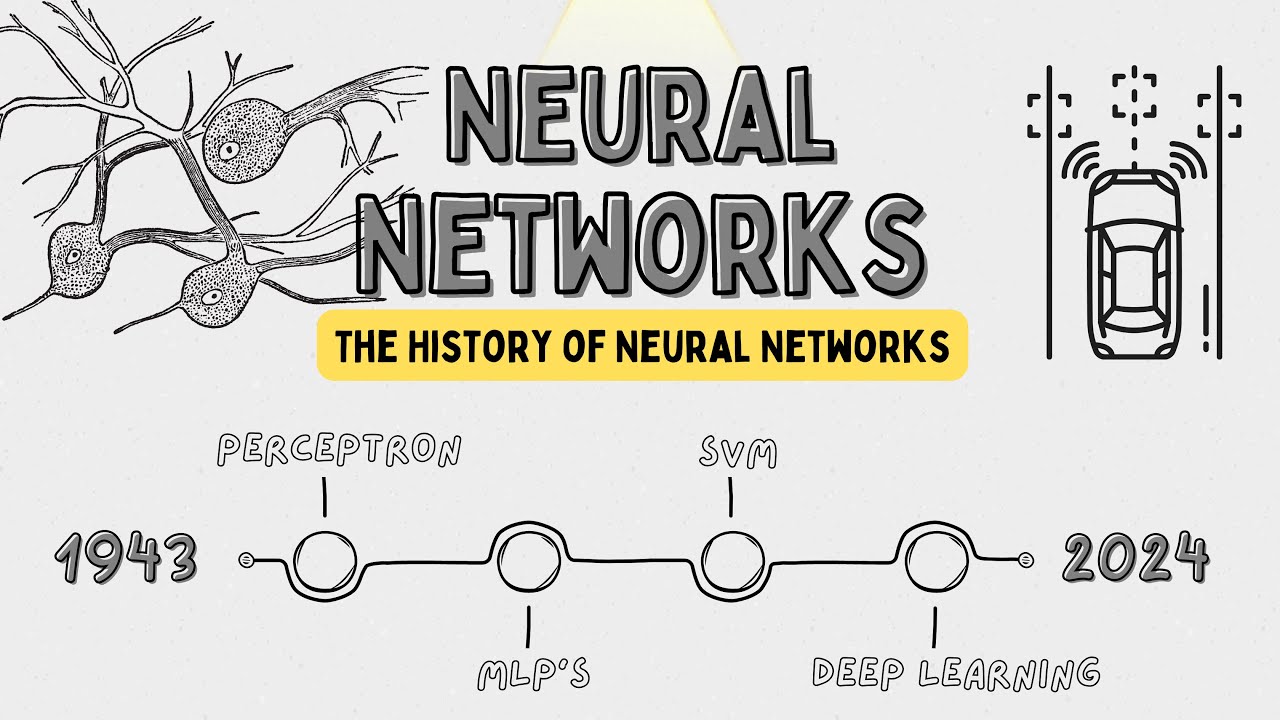

Historien om neurala nätverk börjar egentligen 1943. Då ville forskarna Warren McCulloch och Walter Pitts visa hur neuroner – hjärnans nervceller – arbetar tillsammans. För att göra detta skapade de en modell där elektriska kretsar fungerade på ett liknande sätt som neuroner. På så vis kunde man se hur hjärnan arbetar för att lösa problem och fatta beslut. Trots att det inte var ett riktigt neuralt nätverk lade deras arbete grunden för all framtida forskning inom fältet.

Det skulle dröja till 1957 innan den första fungerande neurala nätverksmodellen, Perceptron, utvecklades av Frank Rosenblatt. Perceptron var ett enkelt program som kunde lära sig binär klassificering med hjälp av inmatad data. Perceptron hade sina begränsningar, men var ett viktigt steg som visade att maskiner kunde lära sig och bli bättre över tid.

På 1980-talet skedde stora framsteg inom neurala nätverk men det största genombrottet kom 1986. Då introducerade Geoffrey Hinton, David Rumelhart och Ronald J. Williams den så kallade backpropagation-algoritmen. Den gjorde det möjligt för neurala nätverk att lösa långt mer avancerade problem än vad som tidigare varit möjligt. Backpropagation-algoritmen hjälper neurala nätverk att lära sig genom att gå baklänges från resultatet och justera varje steg där det blev fel.

AI-vinter under 80-talet

Tekniken gjorde alltså framsteg, men på grund av att beräkningskraften var så pass begränsad minskade intresset för AI och forskningsprojekt hade svårt att få finansiering. Detta ledde till en period i slutet av 1980-talet som kallas för "AI-vinter".

Men datorerna blev snabbare och på 1990-talet började forskare och ingenjörer bygga vidare på tidigare framsteg och utveckla kraftfullare neurala nätverk. En av de viktigaste utvecklingarna under denna period kallades Long Short-Term Memory (LSTM, långt korttidsminne). Denna teknik skapades av Sepp Hochreiter och Jürgen Schmidhuber 1997. LSTM-nätverk kan komma ihåg information över långa tidsperioder, vilket gör dem särskilt användbara för uppgifter som röstigenkänning, maskinöversättning och språkförståelse.

2000-talets kraftiga grafikkort

Men det var i och med grafikprocessorns tillkomst (GPU) som utvecklingen av neurala nätverk började ta fart på riktigt. År 2012 skedde ett stort genombrott. Det var då det neurala nätverket AlexNet, utvecklat av Alex Krizhevsky, Ilya Sutskever och Geoffrey Hinton, blev den överlägsna vinnaren i ImageNet-tävlingen. Det var en prestigefylld tävling inom bildigenkänning. AlexNet visade hur kraftfulla djupa neurala nätverk kunde vara när de tränades med stora mängder data och beräkningskraft. Framgången ledde till en explosion av intresse och investeringar inom djupinlärning och neurala nätverk.

Lär dig mer

- Läs artiklarna om grunderna i AI - artificiell intelligens - på sajten Internetkunskap.